ChatGPT: intelligenza, stupidità o malvagità artificiali?

Ha la risposta a tutto e parla come un libro. Il bot conversazionale di OpenAI, ChatGPT, è il portabandiera di una nuova era dell'intelligenza artificiale (IA). Tuttavia, le sue capacità sono ben lontane da quelle di un cervello umano e la mancanza di un quadro legale preoccupa esperti ed esperte.

Chi ha potuto sfuggire alla valanga ChatGPT? Dal suo lancio quattro mesi fa, e solo in Svizzera, la stampa tradizionale vi ha dedicato in media dieci articoli al giorno, si nota nell’aggregatore di notizie smd.ch. Se si aggiungono le radio, le televisioni, i media online e i social media, si può dire che raramente un prodotto ha beneficiato di una campagna pubblicitaria di tale portata – e completamente gratuita.

Entusiastici all’inizio, i commenti si sono però rapidamente inaciditi man mano che la macchina ha mostrato le sue falle e i pericoli che comporta, dal punto di vista dell’affidabilità delle informazioni fino a quello della protezione dei dati dell’utenza.

Il 29 marzo un migliaio di specialisti della tecnologia ha lanciato un appello, tramite petizioneCollegamento esterno, alle imprese e ai Governi, chiedendo di congelare lo sviluppo dell’IA per sei mesi, evocando “grandi rischi per l’umanità”. Tra di loro Steve Wozniak, co-fondatore di Apple, ed Elon Musk, che oltretutto è uno dei primi finanziatori di OpenAI, l’azienda che sviluppa ChatGPT.

Tre giorni più tardi, l’autorità nazionale italiana per la protezione dei dati ha deciso di bloccare l’accesso al bot, rimproverando ChatGPT di raccogliere e conservare i dati degli utenti per allenare i suoi algoritmi senza nessuna base legale. L’autorità ha chiesto a OpenAI di comunicare entro 20 giorni le misure introdotte per rimediare a questa situazione, sotto pena di vedersi infliggere una multa che potrebbe raggiungere i 20 milioni di euro.

Unsurprisingly, after the pre-mature release of #ChatGPTCollegamento esterno, and the race to the bottom in terms of safety caused by Microsoft, Google or Facebook, GPT-4 is out.

— El Mahdi El Mhamdi | mastodon.social/@elmahdi (@L_badikho) March 14, 2023Collegamento esterno

It claims to "solve" a physics @polytechniqueCollegamento esterno entry exam. This will make it harder to calm down the hype in France… pic.twitter.com/dG47v4Rr8NCollegamento esterno

>> “Senza sorprese, dopo l’uscita prematura di ChatGPT e la corsa al ribasso in termini di sicurezza provocata da Microsoft, Google o Facebook, GPT-4 è stato lanciato”. El Mahdi El Mhamdi fa parte delle voci che criticano l’assenza di regole nel settore dell’AI. Professore al Politecnico di Parigi, ha scritto la sua tesi al Politecnico federale di Losanna sotto la direzione di Rachid Guerraoui. Sono due nomi che ritroveremo più in basso nell’articolo.

Il chatbot è davvero così pericoloso? Non ne ha l’aria, con la sua interfaccia estremamente sobria e la cortesia un po’ compassata che già caratterizzava Siri, Cortana, OK Google e altri.

Per capire meglio, bisogna esaminare più da vicino cosa è questa macchina e, soprattutto, cosa non è.

Un cervello elettronico? Sicuramente no

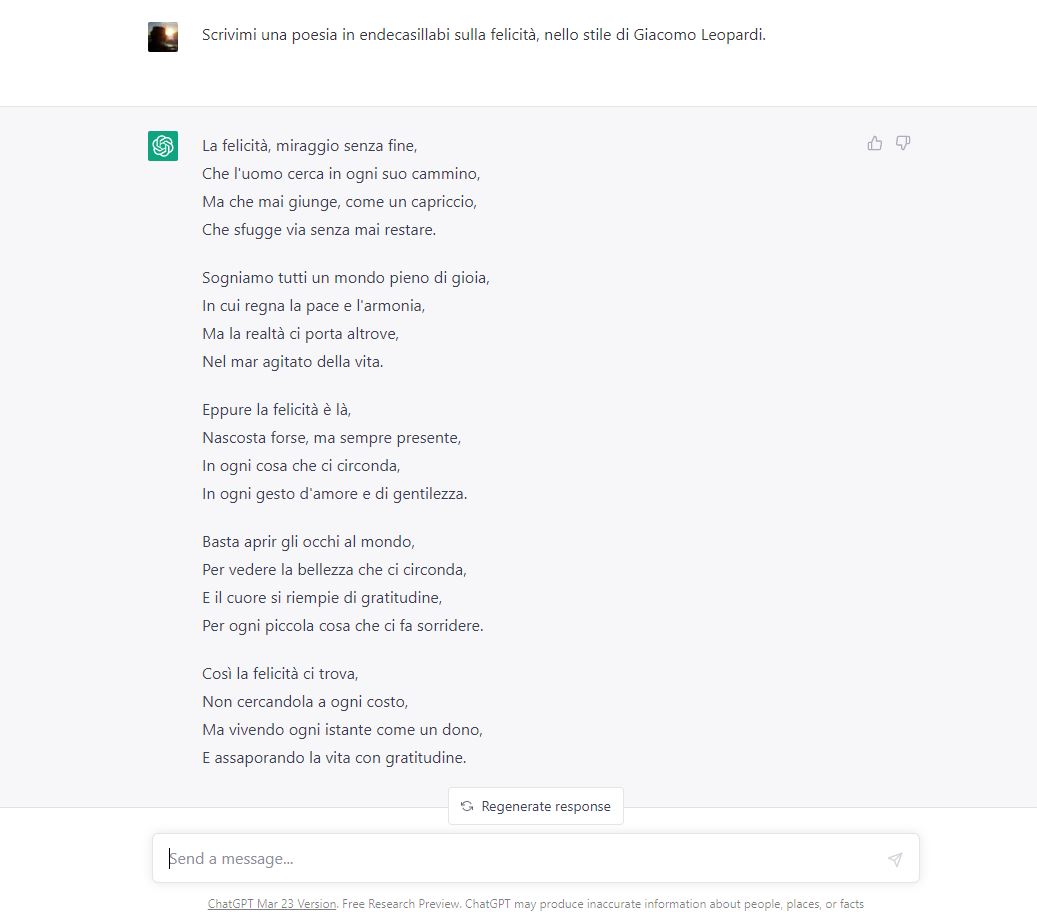

Quando gli si pone direttamente la domanda, ChatGPT non nasconde la propria natura: “In quanto programma informatico, sono fondamentalmente diverso da un cervello umano”. Poi spiega che può trattare enormi quantità di dati molto più velocemente di un essere umano, che la sua memoria non dimentica nulla, ma che è sprovvisto di intelligenza emotiva, coscienza di sé, ispirazione, pensiero creativo e della facoltà di prendere decisioni autonomamente.

Questo perché l’architettura stessa delle IA non ha niente a che vedere con quella del cervello, come spiega brillantemente un libro pubblicato nella sua versione italiana il 23 settembre 2022. Mille cervelli in uno è il frutto del recente lavoro del gruppo di ricerca di Jeff Hawkins. Ingegnere informatico statunitense, negli anni Novanta è stato il padre del Palm, assistente personale tascabile precursore dello smartphone. Riconvertitosi alle neuroscienze, Hawkins è oggi alla guida della società di IA Numenta.

Una delle idee principali del libro è che il cervello crea degli “archivi”, centinaia di migliaia di “mappe” su tutto ciò che conosciamo che modifica di continuo con le informazioni che riceve tramite i nostri sensi. Una AI, al contrario, non ha occhi né orecchie e si nutre solo dei dati che le forniamo, i quali restano statici e non evolvono.

Non sa neanche cos’è un gatto

Hawkins illustra le sue idee tramite semplici esempi. Una AI che etichetta immagini è capace di riconoscere un gatto. Ma non sa che è un animale, che ha una coda, delle zampe e dei polmoni, che alcuni umani preferiscono i gatti ai cani e neanche che il gatto fa le fusa o che perde peli. In altre parole, la macchina sa meno di un gatto di quanto ne sappia un bambino di cinque anni.

Chiedere a ChatGPT se Tintin ha camminato sulla Luna: il trabocchetto è evidente. La macchina non ci casca, precisando subito che il celebre albo a fumetti Uomini sulla luna, del belga Hergé, è un’opera di fantasia. Ma aggiunge che la missione lunare narrata nel fumetto è stata “organizzata da Syldavia e Borduria”.

Ah sì? Eppure, nell’universo di Hergé, Syldavia e Borduria sono un po’ come Ucraina e Russia in questo momento, meno la guerra. Il razzo è un’operazione esclusiva della Syldavia. Quando lo faccio notare, ChatGPT ammette che questi Paesi immaginari “sono spesso presentati come nemici e rivali”, ma insiste: “Il razzo è frutto della collaborazione tra la Syldavia e la Zbroïa Airfix della Borduria.” (Questo non può esserselo inventato… Oppure sì? Neanche Google sa di cosa sta parlando!).

Ma allora, cosa ci fa il colonnello Boris, spia borduriana a bordo del razzo, incaricato di dirottarlo? Senza scomporsi, ChatGPT asserisce: Boris è una spia ed è salito a bordo clandestinamente, ma il razzo è sempre una collaborazione tra la Syldavia e quello che ormai è diventato il “Centro spaziale della Borduria”.

Alla quarta risposta, la macchina ha infine capito che la Borduria non ha niente a che fare con la costruzione del vascello lunare. E siccome è programmata per imparare dai propri errori, giura che non la coglieremo più in fallo su questo argomento. Un’ora più tardi, alla stessa domanda, ChatGPT ha dimenticato la Borduria (e la Syldavia), ma ci dice che il razzo è stato costruito dal professor Trifone Girasole, presumibilmente nel laboratorio dove lavora, “situato in Svizzera, tra le montagne” (!?).

Test realizzato con la versione a pagamento di ChatGPT il 31 marzo 2023.

Perché? Perché il bambino ha già visto un gatto, l’ha accarezzato, l’ha sentito fare le fusa. Tutte queste informazioni hanno arricchito la “mappa” del gatto che ha nel cervello. Un bot conversazionale come ChatGPT, invece, si basa unicamente su sequenze di parole e sulla probabilità che si trovino le une accanto alle altre.

Questi limiti dell’IA come la costruiamo ancora oggi erano stati previsti più di 70 anni fa da Alan Turing, il geniale matematico britannico che gettò le basi dell’informatica. Nel 1950, nel suo articolo Computing Machinery and Intelligence, Turing spiegò già che, se si vuole costruire una macchina che pensa, non basterà programmarla in modo che faccia deduzioni a partire da una massa di dati. Per meritare davvero il loro nome, le intelligenze artificiali dovrebbero essere capaci di ragionare per induzione, ovvero a partire da casi particolari per giungere a una generalizzazione. E sono ancora molto lontane da ciò.

È formulato bene e spesso dice il vero

Rachid Guerraoui dirige il laboratorio di calcolo distribuito al Politecnico federale di Losanna (EPFL). Con il collaboratore Lê Nguyên Hoang, che anima anche il canale Youtube Science4AllCollegamento esterno, ha pubblicato nel 2020 Turing à la plage– l’IA dans un transat (Turing sulla spiaggia – l’IA su una sdraio), libro il cui editore vi promette che, dopo averlo letto, non guarderete più il vostro computer nello stesso modo.

“La maggior parte delle volte, quello che dice è vero. Ma fa regolarmente anche grossi errori. Quindi, non bisogna fidarsi alla cieca.” Rachid Guerraoui, EPFL

Per Guerraoui, uno dei più grandi rischi con ChatGPT è l’eccesso di fiducia. “La maggior parte delle volte, quello che dice è vero o, in ogni caso, è talmente ben scritto che ha l’aria completamente vera. Ma fa regolarmente anche grossi errori. Quindi, non bisogna fidarsi alla cieca”. Purtroppo, non tutti hanno lo spirito critico necessario per rimettere in causa quello che la macchina dice – soprattutto quando lo esprime chiaramente, senza errori di ortografia o di grammatica.

“Un altro pericolo che individuo è che deresponsabilizza la gente”, prosegue il professore. “Molte aziende l’utilizzeranno. Ma qual è la fonte, chi è responsabile se le informazioni fornite sono problematiche? Non è per niente chiaro”.

Guerraoui teme di vedere l’IA sostituirsi a giornalisti, scrittori, insegnanti, come si ipotizza spesso? Non ancora, ma immagina che “alcune professioni potrebbero forse cambiare. Il professore o il giornalista si dovrà piuttosto incaricare di verificare, di eseguire un controllo incrociato delle fonti, perché la macchina produrrà testi che sembreranno plausibili, e nella maggior parte dei casi lo saranno. Ma bisognerà sempre verificare”.

Da regolamentare con urgenza

La grande sfida oggi per l’IA non è la performance, ma la gestione, la regolamentazione e l’esigenza di affidabilità”, sostiene da parte sua El Mahdi El Mhamdi, ex dottorando dell’EPFL, oggi professore di matematica e data science al Politecnico di Parigi.

“Secondo me, ChatGPT non solo è sopravvalutato, ma la sua distribuzione precoce è irresponsabile e pericolosa.” El Mahdi El Mhamdi, Polytechnique, Paris

Nel 2019, ha pubblicato – anche lui in collaborazione con Hoang – Le fabuleux chantier – rendre l’intelligence artificielle robustement bénéfique (Il favoloso cantiere – rendere l’intelligenza artificiale benefica in modo robusto), libro che tratta in particolare dei pericoli dei cosiddetti algoritmi di raccomandazione, quelli che permettono ai social media di proporvi contenuti che dovrebbero interessarvi in funzione del vostro profilo. El Mhamdi non ha atteso l’avvento di ChatGPT per denunciare l’impatto di questi algoritmi sul “caos informativo delle nostre società”.

“Secondo me, ChatGPT non solo è sopravvalutato, ma la sua distribuzione precoce è irresponsabile e pericolosa”, avverte il professore. “Quando vedo l’entusiasmo incondizionato nei confronti di questo strumento, anche tra i miei colleghi, mi chiedo se viviamo sullo stesso pianeta”, aggiunge, ricordando gli scandali di schedatura di Cambridge Analytica o la proliferazione di software spia come Pegasus, che possono essere installati segretamente sui telefoni cellulari.

El Mhamdi ammette che ChatGPT può essere un buon accessorio di lavoro, ma ricorda che la scienza che ne ha permesso la creazione “è frutto di ciò che è stato pubblicato da migliaia di ricercatori e ricercatrici nell’ultima decade, di strumenti ingegneristici colossali e del lavoro eticamente problematico di manodopera sottopagata in Kenya” (vedi riquadro in basso).

In fin dei conti, per lui, “il vero genio di OpenAI non è nella scienza alla base di ChatGPT, ma nel marketing delegato a un pubblico eccitato per questo nuovo gadget”. Un pubblico e anche dei media, potremmo aggiungere per ritornare all’inizio di questo articolo. È vero, tutti ne parlano, ma avete mai visto una pubblicità di ChatGPT, voi?

ChatGPT non fa distinzioni tra le descrizioni di un volo di rondini al di sopra di un campo di tulipani e quella dello stupro di una figlia da parte del padre. Per lui, queste situazioni non sono altro che informazioni – come il dolore per Teminator. Chi sviluppa l’AI deve quindi insegnare alla macchina – che non ha valori, né coscienza, né morale – a riconoscere ciò che è ammissibile da quello che non lo è. Per farlo, bisogna fornire all’IA degli esempi degli atti più abietti di cui è capace l’essere umano, in modo che possa riconoscerli e eliminarli.

Nel gennaio del 2023, un’inchiesta della rivista statunitense TimeCollegamento esterno ha rivelato come OpenAI abbia appaltato la soluzione a questo problema. A partire dal novembre del 2021, OpenAI ha inviato decine di migliaia di testi tossici pescati nei luoghi più oscuri e reconditi di internet alla società californiana SamaCollegamento esterno che le ha fatte analizzare principalmente nella succursale di Nairobi, in Kenya.

Lì, una trentina di persone ha dovuto passare nove ore al giorno a leggere ed etichettare descrizioni dettagliate di abusi sessuali su fanciulli, di atti di zoofilia, di omicidi, di stupri, di tortura,… per due dollari all’ora.

Siccome non si esce indenni da una tale carrellata di orrori, Sama, che vanta il marchio di azienda “etica”, ha fornito a queste persone un sostegno psicologico. Secondo gli ex impiegati che hanno accettato di parlare anonimamente al giornalista del Time, però, era ampiamente insufficiente. Il contratto tra OpenAI e Sama è stato in seguito reciso.

Dal canto suo, ChatGPT non ha memoria di questa pagina poco lusinghiera del suo concepimento. In qualsiasi modo gli si ponga la questione, le risposte girano sempre attorno al famoso: “Spiacente, ma in quanto modello linguistico non ho accesso…/non sono in grado…/non posso fornire informazioni… /non ho la capacità …”.

A cura di Sabrina Weiss

Traduzione: Zeno Zoccatelli

>> È giusto fermare lo sviluppo di sistemi potenti di intelligenza artificiale? Leggete le opinioni divergenti di due esperti:

Altri sviluppi

L’intelligenza artificiale è fuori dal controllo democratico

Altri sviluppi

Governi e aziende non fermeranno la corsa all’IA

In conformità con gli standard di JTI

Altri sviluppi: SWI swissinfo.ch certificato dalla Journalism Trust Initiative

Potete trovare una panoramica delle discussioni in corso con i nostri giornalisti Potete trovare una panoramica delle discussioni in corso con i nostri giornalisti qui.

Se volete iniziare una discussione su un argomento sollevato in questo articolo o volete segnalare errori fattuali, inviateci un'e-mail all'indirizzo italian@swissinfo.ch.